robot txt چیست؟ چه کاربردی در سئو دارد؟ ( چگونه فایل robots txt بسازیم؟ )

قبل از پرداختن به بررسی مفهوم فایل robots.txt، ابتدا بگذارید تا با یک مثال شروع کنیم. تصور کنید که سایت شما مانند یک تالار است که هر روزه افراد زیادی در آن رفت و آمد میکنند. اگر این تالار یک راهنما در نزدیکی درب ورودی برای راهنمایی افراد نداشته باشد، ممکن است تالار به هم بریزد و نظم آن دچار اختلال شود! فایل robots.txt در اینجا به کمک شما میآید.

استفاده از فایل robots.txt از اهمیت بالایی برخوردار است و اگر میخواهید عملکرد سایت خودتان را بهبود ببخشید، استفاده از این فایل به شما پیشنهاد میشود. در این مقاله به بررسی مفهوم، اهمیت و نحوه استفاده از فایل robots.txt میپردازیم. در ادامه با ما همراه باشید.

فایل robots.txt چیست؟

تنها افراد عادی نیستند که به سایت شما سر میزنند؛ بلکه رباتهای گوگل نیز در دورههای زمانی مختلف از سایت شما بازدید میکنند و به این کار Crawl گفته میشود. بازدید رباتهای گوگل از سایت شما به دلیل یافتن صفحات جدید یا ایندکس کردن صفحات سایت انجام میشود.

فایل robots.txt یک فایل متنی است که نحوه کراول کردن رباتها و ایندکس کردن صفحات در سایت را مشخص میکند؛ یعنی به طور کلی، به رباتهای گوگل برای سر زدن و گردش در سایت راهنمایی میرساند.

فایل robots.txt از پروتکل REF یا Robots Exclusion Protocol تشکیل میشود که لینکهای فالو و نوفالو هم جزء همین پروتکل هستند. این فایل توسط وبمسترها برای رباتهای گوگل ساخته میشوند تا از طریق آن به رباتها دستور دهند کدام صفحات سایت را کراول یا ایندکس کنند و کدام صفحات را خیر؛ بنابراین اگر بهعنوان یک متخصص سئو، وبمستر یا مدیر سایت فعالیت میکنید، در ادامه این مقاله جزئیات بیشتری درباره نحوه استفاده از این فایل را در اختیار شما میگذاریم.

نحوه عملکرد فایل robots.txt

رباتهای گوگل به دو روش سایت ما را بررسی میکنند:

۱- از طریق لینکها

۲- از طریق فایل robots.txt

– از طریق لینکها

بررسی سایتها توسط رباتهای گوگل از طریق لینک به این صورت است که رباتهای گوگل، لینکهای داخلی که در سایت قرار داده شده است را دنبال میکنند و با استفاده از آنها به تغییرات و صفحات جدیدِ سایت ما دسترسی پیدا میکنند؛ در نتیجه تصمیم میگیرند که صفحات جدید را ایندکس کنند یا خیر.

به عبارت دیگر، رباتهای گوگل ابتدا وارد وبسایتمان میشوند و از طریق لینکهایی که در صفحه اصلی و منوی سایت قرار دارند، به صفحات جدید دسترسی پیدا میکنند و اگر صفحات جدید نیز دارای لینکهای داخلی بودند، آنها را دنبال میکنند.

– از طریق فایل robots.txt

در روش اول، رباتهای گوگل لینکها را دنبال میکردند؛ اما اگر شما در سایتتان از فایل robots.txt استفاده کرده باشید، رباتهای گوگل ابتدا به سراغ آن میروند و دستورات شما را میخوانند؛ به عبارت دیگر، شما با استفاده از فایل robots.txt امکان این را دارید که صفحاتی که میخواهید از طریق گوگل بررسی شوند را انتخاب کنید و رباتهای گوگل نیز با استفاده از این فایل، طبق دستورات شما سایت را کراول میکنند.

اهمیت استفاده از فایل robots.txt

شما میتوانید با استفاده درست از فایل robots.txt، نحوه عملکرد سایت خودتان را بهبود ببخشید و این فایل میتواند برای شما بسیار مفید باشد. در این بخش به بررسی نکاتی میپردازیم که اهمیت استفاده از فایل robots.txt را برای شما شفاف میکنند.

— جلوگیری از کنیبالیزیشن

گاهی اوقات پیش میآید که دو صفحه از سایت شما در صفحه نتایج گوگل رتبه میگیرند و در این صورت کاربر دو صفحه یکسان از وبسایت شما را مشاهده میکند؛ به این اتفاق کنیبالیزیشن میگویند که به هیچ وجه برای ترافیک سایت شما مفید نیست.

زمانی که این اتفاق رخ میدهد، شما میتوانید با استفاده از فایل robots.txt، صفحات تکراری در سایتتان را مشخص کنید و دستور ایندکس نشدنِ آنها را بدهید.

— جلوگیری از ایندکس شدن فایلهای خاص در سایت شما

اگر شما در سایتتان فایلی دارید که نمیخواهید در نتایج جستجو در گوگل نشان داده شوند (PDF، عکس و ویدیو)، میتوانید به راحتی با دستور ایندکس نشدن از طریق فایل robots.txt، از نمایش آنها در گوگل جلوگیری کنید. این قابلیت میتواند برای سایتهایی که فایل و دورههای آموزشی میفروشند، بسیار مفید باشد.

— جلوگیری از نمایش برخی از محتواهای سایت شما

برخی از محتواها در سایت شما وجود دارند که دوست ندارید تا در نتایج جستجوی گوگل به نمایش گذاشته شوند (درباره ما و تماس با ما). در این صورت میتوانید از طریق فایل robots.txt دستور ایندکس نشدنِ آنها را بدهید و از این کار جلوگیری کنید.

— مدیریت ترافیک رباتها

اگر شما هیچ معیار مشخصی برای بازدید رباتها از صفحات سایتتان نداشته باشید، تعداد رباتهایی که برای کراول کردن به سایت شما سر میزنند، در مقایسه با وقتی که این معیار را دارید بیشتر است.

برخی از سرویسهای میزبانی؛ دارای محدودیت هستند و ممکن است به دلیلِ این موضوع بعضی از سایتها به مشکل بر بخوردند. شما میتوانید با استفاده از فایل robots.txt، ترافیک رباتهای گوگل را مدیریت کنید و مانع بروز اختلال در سرورِ میزبانی سایتتان شوید در نتیجه تاثیر بهتری در دیده شدن صفحات مهم شما دارد که ممکن است موجب ورود به گوگل دیسکاور نیز شود.

انواع دستورات در فایل robots.txt

همانطور که در بخشهای قبلی گفته شد، شما میتوانید با استفاده از فایل robots.txt، دستورات مختلفی را اعمال کنید که شامل موارد زیر هستند:

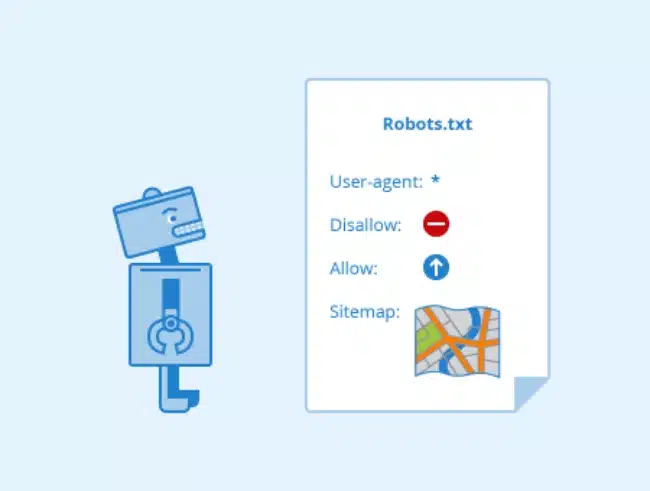

- User-agent

- Disallow

- AllowSitemap

- crawl-delay

در این بخش به بررسی هر کدام از این دستورات و کاربرد آنها میپردازیم.

* دستور User-agent

این دستور در زمانی استفاده میشود که شما میخواهید یک ربات خاص را هدف بگیرید. همچنین شما میتوانید برای این دستور از علامت * نیز استفاده کنید که به معنای اعمال دستور برای همه رباتها است. از این دستور به شکل های زیر استفاده میشود:

User-agent:*

در نظر گرفتن همه رباتها

User-agent:*……bot

در نظر گرفتن یک ربات خاص

* دستور Disallow

شما میتوانید با دستور Disallow مشخص کنید که رباتهای گوگل، کدام صفحات از وبسایت شما را crawl نکنند. به عبارت دیگر، کاربرد این دستور برای نمایش ندادن محتواهای دلخواه در نتایج جستجوی گوگل است. نحوه استفاده از این دستور به صورت زیر است:

User-agent:*

Disallow: /file

* دستور Allow

با استفاده از دستور Allow میتوانید به رباتهای گوگل اجازه دهید تا به به فولدری که قبلا دستور Disallow را روی آن اعمال کردید دسترسی پیدا کرده و فایل انتخابی شما را کراول کند. شما میتوانید به صورت زیر از دستور Allow در فایل robots.txt استفاده کنید.

User-agent:*

Disallow: /file

Allow: /file/X.jpg

* دستور Sitemap یا نقشه سایت

برای دسترسی به نقشه سایت، روشهای زیادی وجود دارد که یکی از رایجترینِ آنها، نوشتن نقشه سایت در فایل robots.txt است. توجه داشته باشید که با این کار، فایل نقشه سایت شما در موتورهای جستجوی مختلف مانند بینگ و فایرفاکس پشتیبانی میشود.

* Crawl-delay

با استفاده از این دستور میتوانید مشخص کنید که رباتهای خزنده باید چند ثانیه برای کراول کردن سایت شما صبر کنند. این دستور میتواند روی سرعت لود شدن سایت شما تاثیر مستقیم بگذارد و باید بتوانید از آن به درستی استفاده کنید.

نحوه استفاده از فایل robots.txt

استفاده از فایل robots.txt بسیار راحت است و تنها با قرار دادن یک عبارت در انتهای آدرسِ سایتتان میتوانید به فایل robots.txt دسترسی داشته باشید و دستورات مختلفی را روی آن اعمال کنید. شما میتوانید با اعمال پسوند robots.txt/ در آدرس سایتتان، به فایل robots.txt دسترسی داشته باشید.

همچنین اگر شما میخواهید روی فایل robots.txt ویرایشهایی انجام دهید و یا دستوراتی که در بخشهای قبلی ذکر شد را روی این فایل اعمال کنید، میتوانید به بخش Root سایتتان مراجعه و فایل robots.txt را در آنجا مشاهده کنید.

نکاتی درباره استفاده بهتر از فایل robots.txt

برای استفاده از این فایل اطمینان حاصل کنید که محتواها یا بخشهایی از سایتتان که میخواهید کراول و ایندکس شوند را مسدود نکردهاید.

پیشنهاد میشود که برای جلوگیری از محتواهای حساس از نمایش در نتایج جستجو، از فایل robots.txt استفاده نکنید؛ زیرا با استفاده از دستور Disallow در این فایل، تضمینی برای کراول و ایندکس نشدنِ محتوای انتخابی شما وجود ندارد و شما بهتر است برای این کار از دستور متنی Noindex استفاده کنید.

سخن آخر

در این مقاله از ایران هاست ( ارائه دهنده خدمات ثبت دامنه .ir ) با بررسی فایل robots.txt، کاربردها و نحوه استفاده از آن همراه شما بودیم. باید گفت قابلیتهای زیادی مانند فایل robots.txt وجود دارند که شما میتوانید با استفاده از آنها، عملکرد سایت خود را بهبود ببخشید و از رقبا پیشی بگیرید؛ لذا بهتر است تا دست از تحقیق درباره این ابزارها و امکانات بر ندارید و هر روز درباره یکی از آنها مطالعه کنید.